第6回 YUVとデータレベル

|

YUVが生まれた背景YUVが登場した頃は、まだテレビは4:3のアスペクト比でした。アナログのカラー放送の送受信方式は日本や米国で採用されたNTSCと欧州や中国で採用されたPALなどがあり、今以上に規格間での変換は困難な時代でした。当時のイギリスにはQuantel社という、王室が見学に訪れるような歴史ある映像機器メーカーがありました。そこで開発されていたノンリニア編集合成システム「Harry」は、現在から振り返っても業界に与えた影響は多大でした。イギリスのテレビ送受信方式はPAL。日本のNTSCとは大きく異なります。そのHarryの機器背面には、アナログ入出力のためのYUVコネクタがありました。YUVコネクタは、PAL方式でのアナログコンポーネント接続のBNC端子が3つセットになったものです。このHarryのNTSC版が日本にやってきても背面コネクタの表記はYUVのままだったので、NTSCでもアナログコネクタのことをYUVと呼ぶようになっていきました。当時アナログ信号はコンポジット映像信号が主流でしたが、クオリティを高めるためにRGBや色差信号を扱うコンポーネント映像信号を使うことが増え始めていました。 |

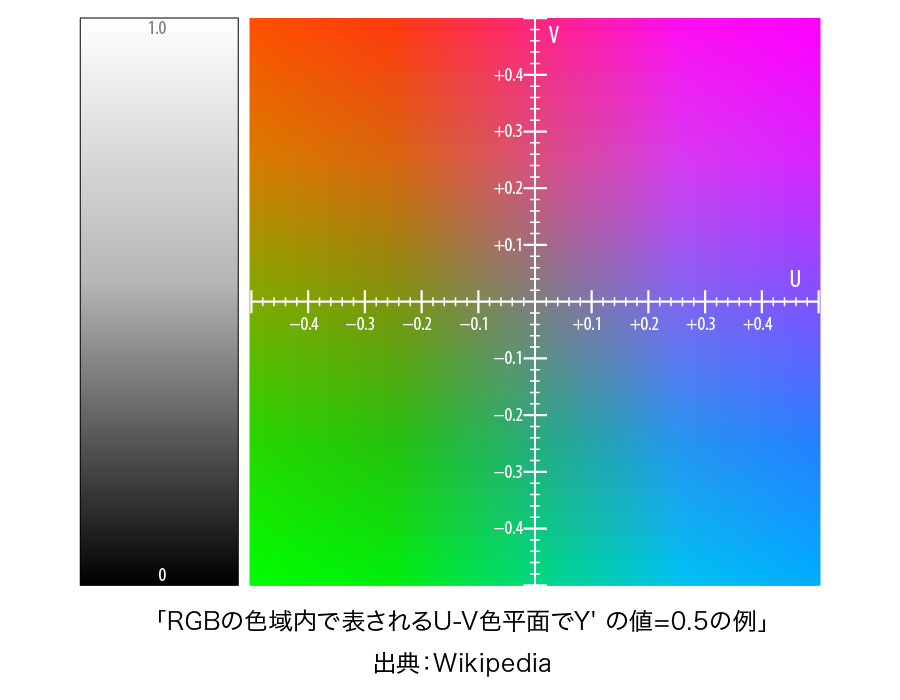

カラー放送開始の頃、家庭に放送を伝送するために映像は電波に乗せることになるので、チャンネル数を一定数確保するために、電波の帯域を抑えることが必要でした。現在のように、視聴者が豊富なチャンネルから自由に選択できる時代ではなかったのです。そこで電波帯域を抑えるために考案されたのが、人の光に対する性質でした。人は輝度変化には敏感でも、色の違いには鈍感であるという特徴があります。網膜を形成する視細胞の輝度を受け持つ細胞の数が、色を受け持つ細胞の数よりも多いことに起因しています。電波に乗せて伝送する際には、輝度は帯域制限せずに送り、色成分はRGBの3要素から2つの要素に変換してから帯域を半分に抑えて伝送することになりました。テレビ信号で見かけるY,R-Y,B-Yは「Y:輝度・同期信号」「R-Y、B-Y:色差信号」を指しています。

先ほど紹介したQuantel社のHarryが日本にやってきた1990年代前半は、映像処理でアナログからデジタルへの移行期でもありました。そこにアナログコンポーネント信号が使われるようになり、信号の形式が混在して厄介な時代でもありました。アナログコンポーネント信号をデジタル化したデータストリームの名称をYUVと呼ぶようになったのは、このような時期でした。

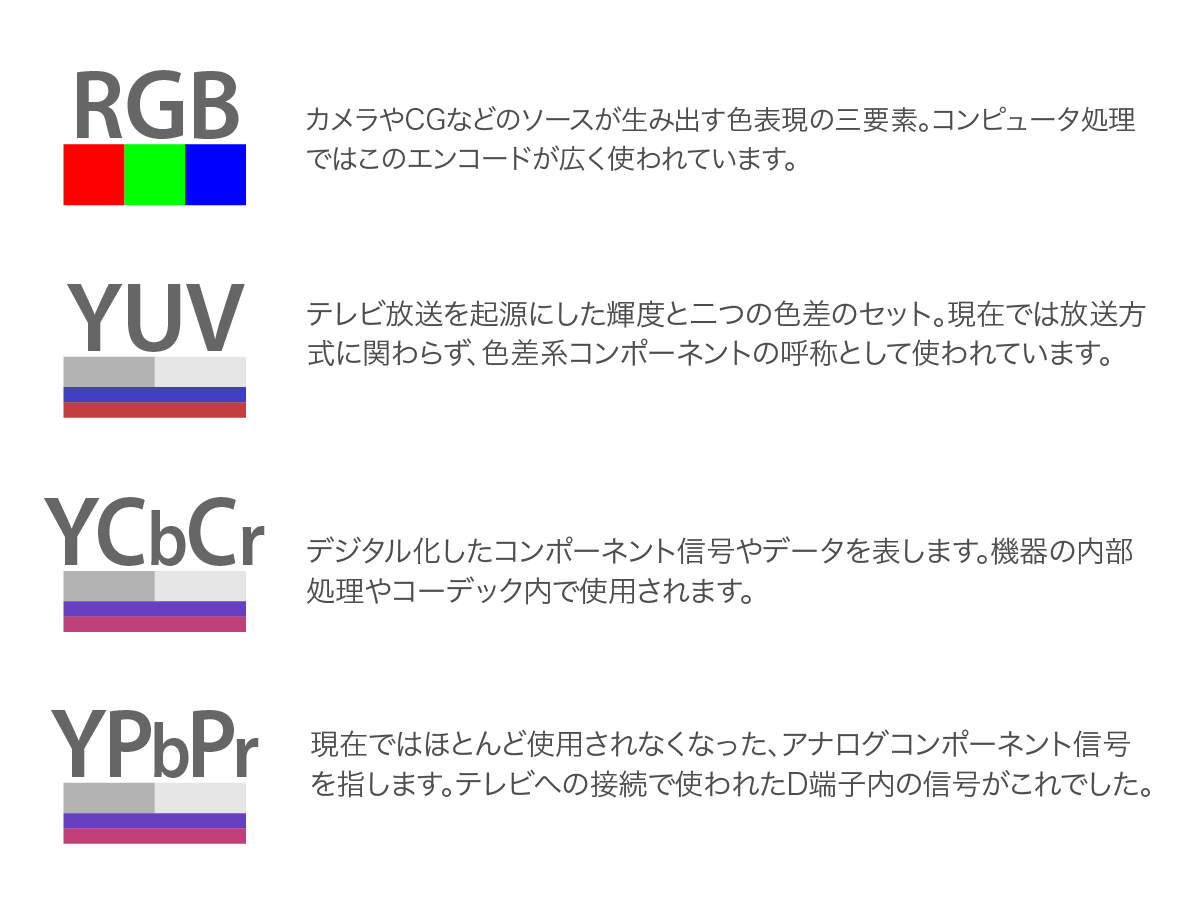

アナログコンポーネント信号を示す用語には、先に述べたY,R-Y,B-Yをはじめ、YPbPrやYCbCrもあります。Harryがやってきた頃の放送用VTRは、ベータカムとM規格の二大勢力があり、それらもアナログコンポーネント記録だったので、まさにアナログコンポーネントの時代でもありました。現在でも残っている表記としてはYCbCrは覚えておくと良いでしょう。YCbCrは、コンポーネント信号のデジタル版なのです。Appleの映像圧縮フォーマットProRes422HQは色差系のコンポーネントデータにエンコードしますが、その要素がY、Cb、Crの3つなのです。

映像信号の処理では、カメラで撮影したRGB信号を元にして、電波で伝送する前段階で色差系のY,R-Y,B-Yに変換しています。この時に帯域を抑えているので、家庭のテレビで電波からRGB信号に戻した際には、放送局でのオリジナル信号とは同じクオリティにはならない原理でした。現在で言うところの、JPEG画像の非可逆圧縮のような処理です。YUV形式のデータ圧縮はJPEG画像にも使われていることをご存知でしたか?YUVは動画系だけの用途ではないのです。

ピクセルとYUVの関係

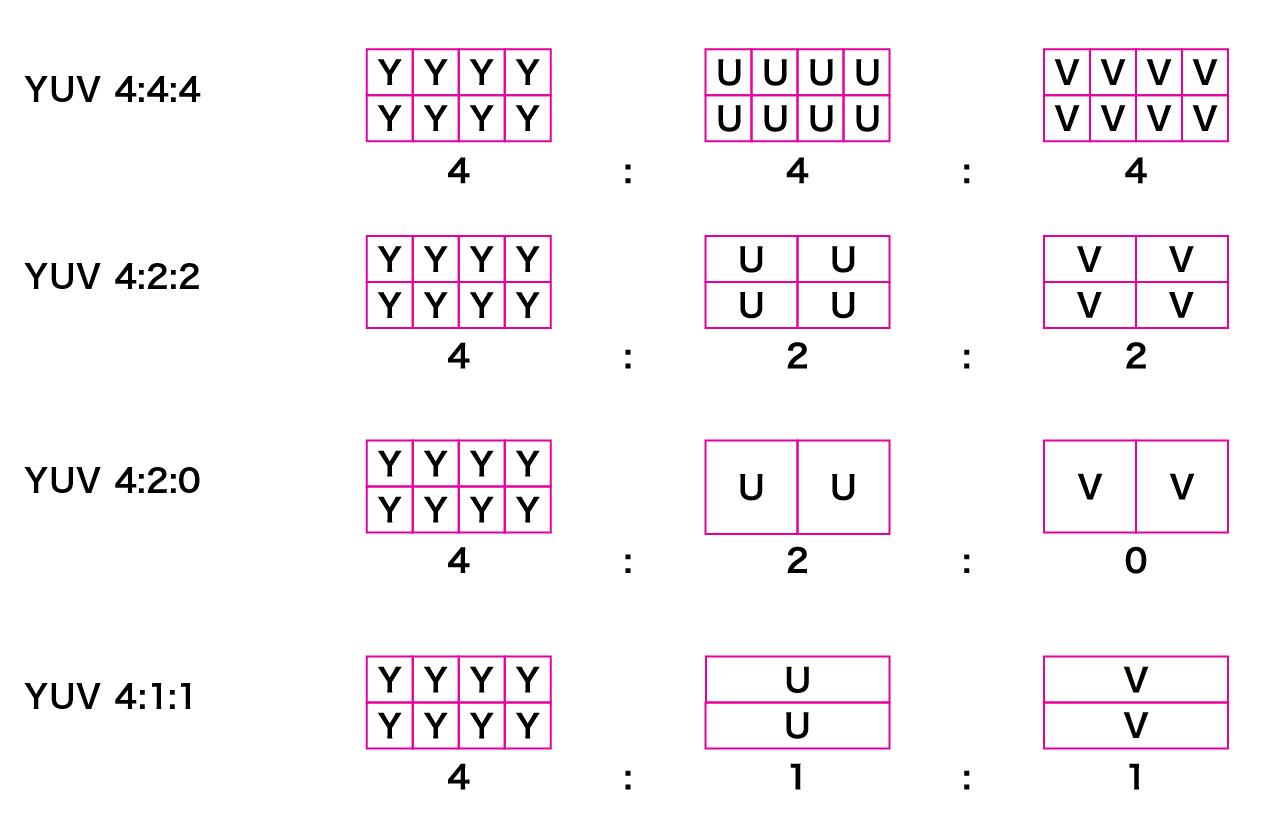

通称YUV、別の表現をすると色差系のカラーエンコード方式では、画像を構成するピクセルに含まれる色情報はどのようになっているのでしょうか。RGB形式では、ひとつのピクセルで表現できる色は、RGB3色の混ぜ合わせで表します。8-bitでは各0〜255の範囲でデータを維持できます。YUVでも同じように1つのピクセルの中にYUV3つのコンポーネントが含まれているかというと、そうではないのが難しく感じるポイントだと思います。ひとつのピクセルの中にYUVすべての要素を保持できるのは、YUVの中でもYUV4:4:4だけなのです。その派生系のYUV4:2:2、4:2:0、4:1:1は複数の隣接するピクセルにまたがってUとVの情報を保持します。これらのどれでも、Yは各ピクセルの中に情報を持っています。

図のように各種YUVエンコード方式では、色差成分のUとVの情報は複数のピクセルにまたがります。YUV4:2:0では縦方向のピクセルのラインも複数にまたがっているので、データ量削減に大きく貢献していることがわかります。その反面、クオリティの劣化を招いてしまう可能性も高まります。YUVエンコードでのアーティファクト(視覚的に感じる画像の劣化)は、細かな絵柄の映像においてはその精細さが損なわれることがあると一般的に言われています。例を挙げると、細かな刺繍を撮影したクローズアップや、瓦屋根が多く並ぶ街のロングショットなどのような細かい絵柄で色が濁った印象に見えることがあります。

ただし、私のこれまでの映像業界での経験の中で、YUVエンコードが招いたカラーアーティファクトに遭遇したことはほとんどありません。撮影素材を並べ替える編集作業では、大きな影響は出ないほどの優れたエンコード方式だったと私は考えています。ただし、です。ピクセル単位で処理を精細に行うコンポジット作業では、一転してYUVは敬遠されていると聞いています。RGBとYUVの記録方式の違いによるクロマキーの抜け具合や、精細なカラーコレクションでは結果に違いが出ることは私も理解しています。YUVでの原理的な弱点を踏まえて、ワークフローに照らし合わせてRGBにするべきか、YUVでも十分なのかを賢く計画することが制作者には求められます。

モニターを使う際の注意点

動画のモニタリングにモニターを使用する際には、HDMI接続を多用することになります。コネクタの変換でHDMIからDVIやDisplayPortにしてから接続することは可能ですが、コントラストが正確に表示できないことがあります。動画のモニタリング用途としてColorEdgeなどの制作モニターを使用するのなら、HDMI接続を基本とすることを強くお勧めします。クオリティを維持した動画モニタリングではDVIやDisplayPortでの接続は避けるべきでしょう。

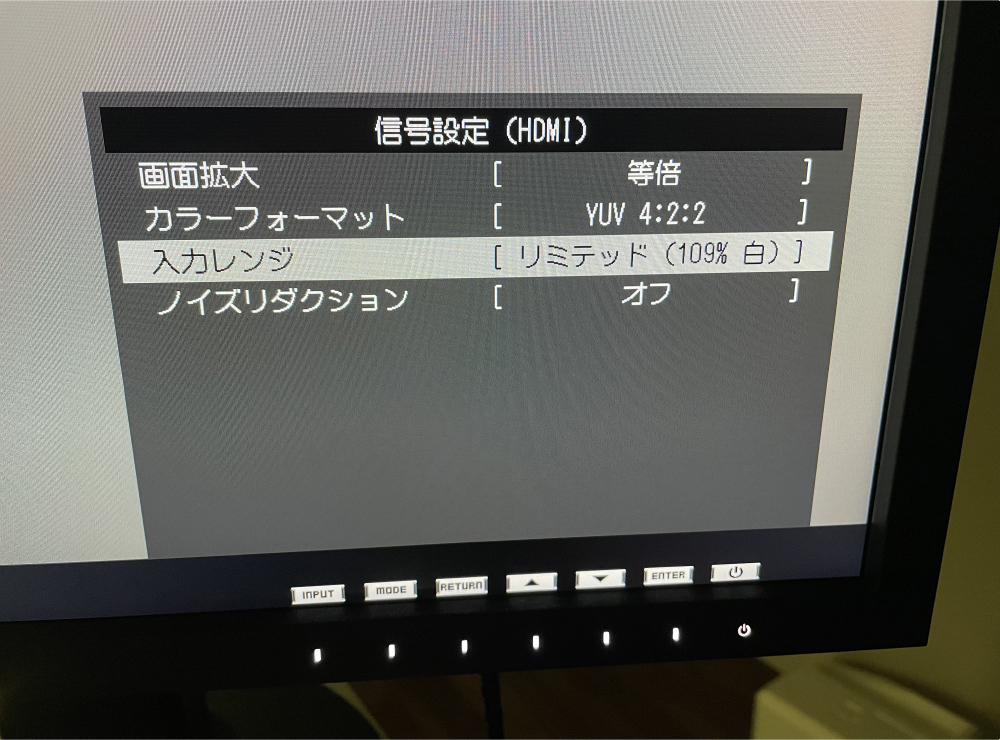

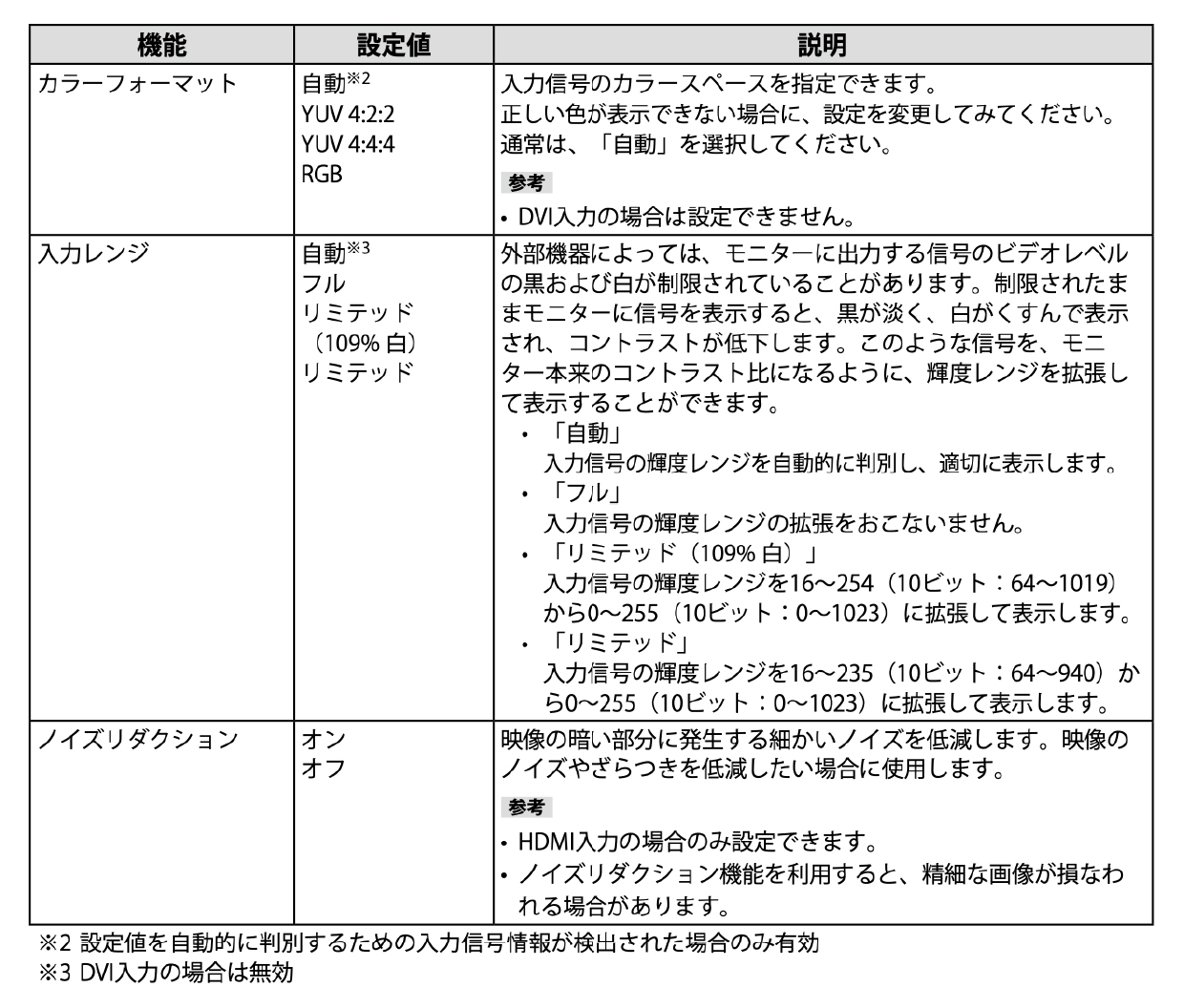

私が現在使用しているColorEdge CS2410では、HDMI接続した際の信号に関する設定項目は写真のようになっています。HDMI接続では入力源の情報から、RGBかYUVかをモニターが自動的に判別し、適切に表示しています。基本的に「自動」で問題ありませんが、正しい色や階調で表示できない場合はカラーフォーマットと入力レンジを信号に合わせて適切に設定する必要があります。動画系のハードウェアメーカーではYUVが、PC系のメーカーではRGBがカラーフォーマットの設定値のデフォルトになっていることが多い傾向にありますが、安価なモニターではそもそも設定できない場合があり、注意は必要です。ColorEdgeではYUVにはYUV4:2:2とYUV4:4:4の2タイプが選択できますが、周りを見渡してHDMI接続でYUV4:4:4を送り出せる信号源はほとんどないと言えるので、現実的にはRGBかYUV4:2:2の二者選択になります。

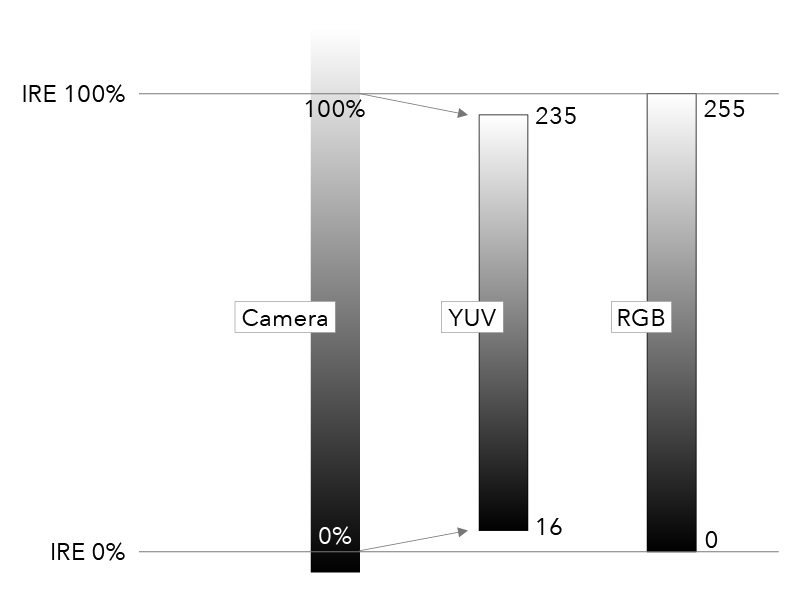

| もうひとつの設定項目である入力レンジに関して、今回改めてじっくり解説したいと思います。RGBとYUVが混在する現状では、この入力レンジの背景にある技術的なところがとても重要になるからです。一般的にデータレンジと呼ばれる技術があります。コンピュータで表現する際に使われてきたRGBは8-bitでは0から255の値を持ちますが、映像信号をデジタル化した際の値の持ち方は若干異なります。映像信号はレベル100%が最大値ではなく、実はその上に10%弱余裕を持たせていました。この明るい白の領域をスーパーホワイトと呼びます。さらに言えば、0%以下のレベルも信号としては表現できる領域を持っていました。こちらはスーパーブラックと呼びます。これによりデジタル信号にエンコードする際には、コンピュータで維持できる0から255の中にどのように信号を送り込むかで、いくつかの処理が考えられます。映像信号の0%から100%だけを切り取って、その外側は無視してデータには反映しない方法。なるべく映像信号の情報を維持するために、0%から最大値の109%までをデータ化する方法。前者をフルレンジ、後者をビデオレンジと呼んでいます。 |

ColorEdgeの信号設定 |

|

諸事情を考慮してデジタルデータへの処理では、映像信号の黒から白の間をデジタルデータの16から235にエンコードすることにしました。RGBでは白ピークが255なので、コード値で20も開きが発生します。しかし、このエンコード方法により、映像信号の100%を超える領域もデジタル化した際に損なわれることがなくなりました。通称このようなデータレベルの取り方のことを、16-235ビデオレベルと呼びます。これに対して、0から255の全データ領域をフルに使い切ることをデータレベル(フルレベル)と呼びます。 このように信号がHDMI接続でColorEdgeにやって来ると、最も暗いコード値16はRGBでの0に比べて黒浮きしているように見えてしまいます。白ピークの235の方は、やや暗めの白のように映ります。そこで16-235入力時の設定に選択肢を持たせています。ColorEdgeの入力レンジ設定で「リミテッド」にしておくと、ソースのコード値16が輝度レベルの最小値、ソースのコード値235が最大値として表示できるようになります。その代わりに、コード値235以上の階調はクリップして235と同じ輝度に表示されます。リミテッドでは、ビデオレベルの100%がColorEdgeの最も明るい輝度で表示できますが、失われる信号領域の階調が発生することになります。 |

|

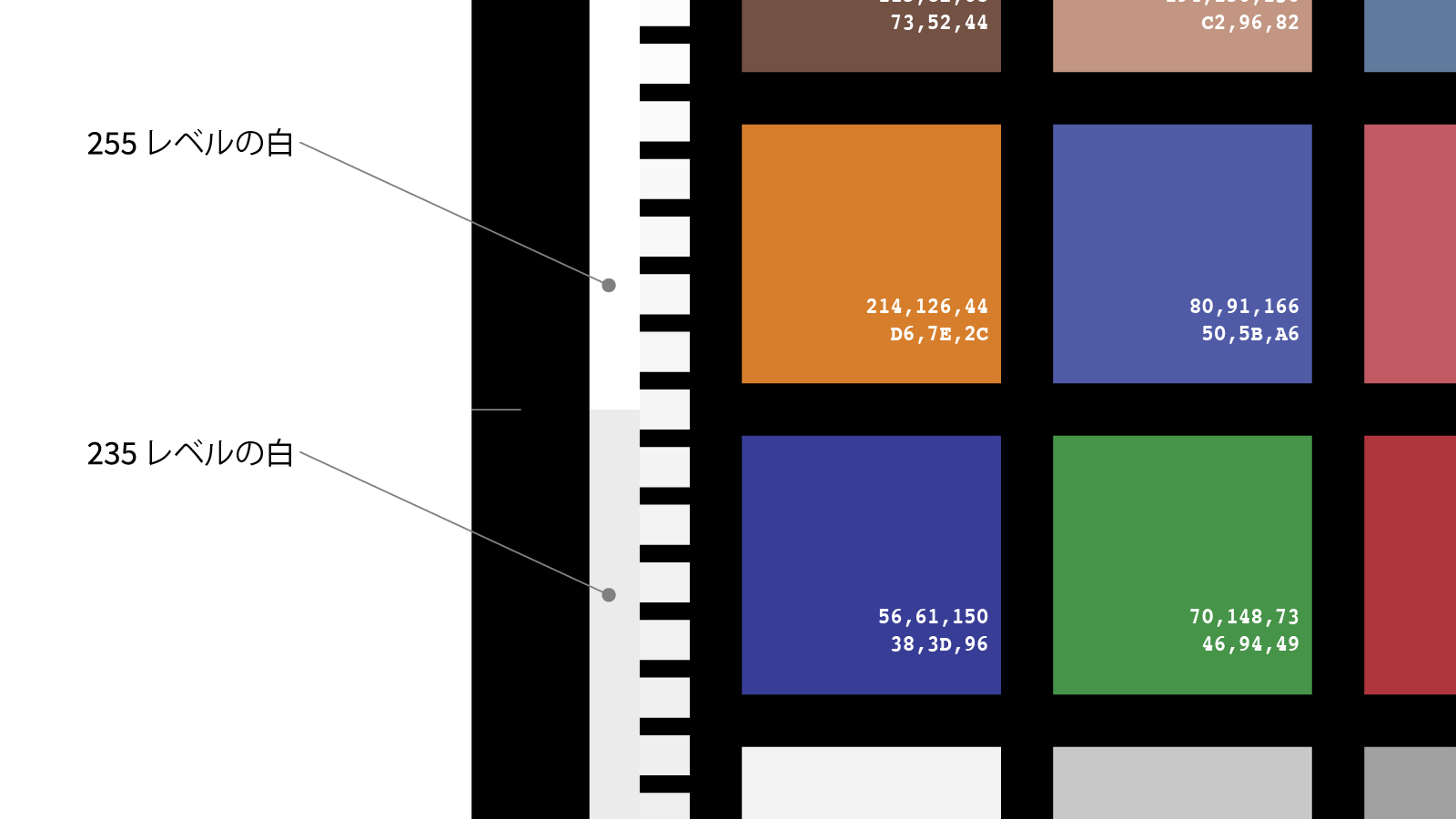

これを確かめるために、信号源のDaVinci Resolveに以前にも紹介した私が作成したテストチャートを読み込んで確認してみました。このチャートの左端には白の235と255という二段階の部分を設けています。この上下の部分の明るさの違いを見ると、ソースのレベル差がモニターで正確に表示できていることが確認できます。

テストチャート

今回確認したColorEdgeとDaVinci Resolveの組み合わせでは、私が使用したビデオI/OがUltraStudio Monitor 3Gだったため、RGB信号固定になっていました。DaVinci ResolveからYUV出力では確認できませんでした。ColorEdgeのカラーフォーマットを「RGB」、入力レンジを「フル」にすると、235と255の白の違いが確認できました。ただし、入力レンジを「リミテッド」にしてしまうと、235と255のレベル差はなくなり235以上の階調がクリップしていました。

次にソース源をATEM miniに切替えて確認を続けました。この機材を選択した理由は、HDMI出力がYUV固定だからです。同じチャートをATEM miniから出力したところ、入力レンジをどれに設定しても235と255の階調の違いは維持できていました。先のDaVinci Resolveからの色と同じ見え方にするには、入力レンジを「リミテッド」に設定する必要がありました。

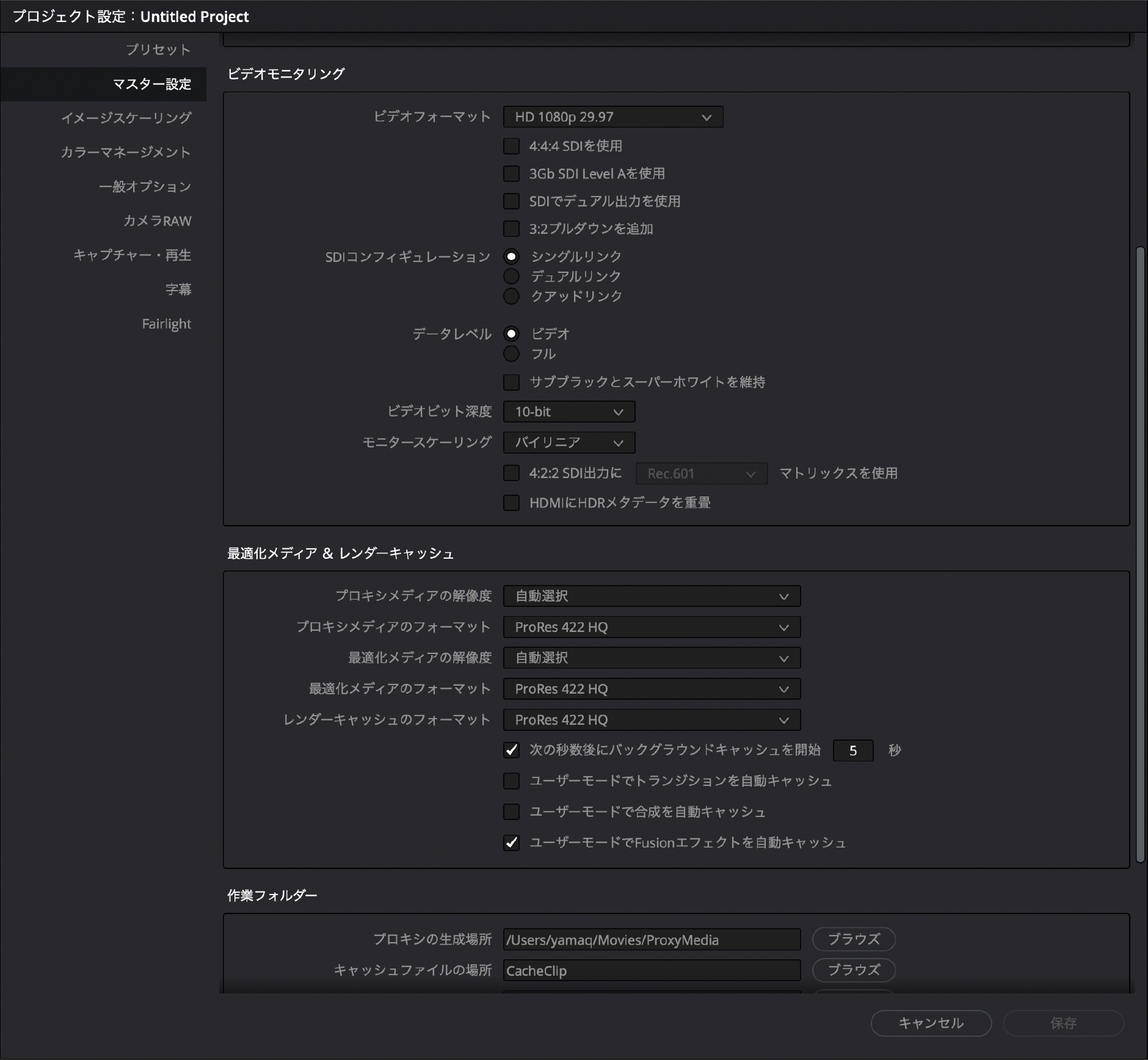

DaVinci Resolveでは、モニターやファイルへの入出力など、DaVinci Resolveから見て外界との接点には必ずデータレベルの設定が選択できるようになっています。以下のスクリーンショットは、DaVinci Resolveのプロジェクト設定の中にあるモニタリングの設定部です。今回のように使用するビデオI/Oによっては、RGBに固定されることもあるので、設定する際には出力される信号フォーマットのチェックも欠かせません。また、ColorEdgeの該当部分のマニュアルからの抜粋もご覧いただくと、データレベルの処理について理解を深められると思います。このように、入力信号のフォーマットとデータレベルをしっかり読み取り、適切に表示できる設定を持つモニターを選ぶことが重要です。

DaVinci Resolveモニタリング設定画面

ColorEdge取扱説明書から抜粋

今回の解説では、YUVの処理系の厄介な面がクローズアップされたかもしれません。理想的にはRGBが望ましいものの、ファイルサイズやデータレートを抑えるための処理としては、YUVにも一定の利点はあります。写真系のJPEGデータでも採用されていることを考えても、RGBだけに収束していくとは考えにくく、ユーザーはRGBとYUVの変換時の注意点を理解して、その対策を準備することが必要であると言えます。

カラーワークフロー連載の最新記事をいち早くお知らせするメールマガジンを発行しています。登録はこちらから

|

Webセミナーのお知らせ

|

|

筆者紹介|山本久之 |

RGBに対するYUVは、RAWとLogのように共通点はあるものの、明らかに素性の異なる者同志という理解は広まっていると思われます。しかし、その先にある詳細な違いへの理解は深まっているとは思えません。そこで、YUVに対する基礎知識を改めて見直して、モニターを使う上での注意点を確認していきましょう。

RGBに対するYUVは、RAWとLogのように共通点はあるものの、明らかに素性の異なる者同志という理解は広まっていると思われます。しかし、その先にある詳細な違いへの理解は深まっているとは思えません。そこで、YUVに対する基礎知識を改めて見直して、モニターを使う上での注意点を確認していきましょう。

テクニカルディレクター、日本大学藝術学部写真学科講師

テクニカルディレクター、日本大学藝術学部写真学科講師